Daten aus der Google Search Console (GSC) zu sichern ist für digitale Marketer und SEO-Spezialisten entscheidend, da GSC-Daten wichtige Einblicke in die Leistung von Websites geben. Leider speichert Google nur 16 Monate dieser Daten. Um sicherzustellen, dass man niemals den Zugriff auf wichtige historische Daten verliert, ist die Einrichtung eines automatisierten Backup-Prozesses mit Google Cloud, Docker und Python eine effektive Lösung. In dieser Anleitung zeigen wir Ihnen den Prozess, wie Sie Google Search Console Backups mit einem Python-Skript, einem Docker-Container und einer Google Cloud-Bereitstellung konfigurieren.

tl;dr: Mit Docker, Google Cloud und Python können Sie eine automatisierte Backup-Lösung für Ihre Google Search Console-Daten einrichten. Mit Cloud Run entfällt die Notwendigkeit der traditionellen Serververwaltung, während Google Cloud Storage sicherstellt, dass Ihre Backup-Daten sicher und leicht zugänglich sind. Diese Lösung spart Ihnen Stunden an Arbeit und verhindert Datenverlust, sodass Sie sich auf das Wachstum Ihres Unternehmens konzentrieren können.

- Was wird benötigt?

- Ein Google Cloud-Konto und Google Cloud SDK

- Zugriff auf die Google Search Console

- Docker

- Einrichten des Python-Skripts

Der Kern dieses Backup-Prozesses ist ein Python-Skript, das Daten aus GSC abruft. Sie können den Google API-Client verwenden, um auf die Search Console-Daten zuzugreifen und diese dann im CSV-Format zu speichern.- API-Authentifizierung: Das Skript verwendet IAM-Anmeldeinformationen zur Authentifizierung, sodass Sie keine Servicekonto-Anmeldeinformationen manuell verwalten müssen.

- Abrufen von GSC-Daten: Das Skript ruft Daten wie Klicks, Impressionen, Durchschnittsposition und CTR aus der Google Search Console für die letzten 30 Tage ab.

- Datenexport: Anschließend wird die Daten in eine CSV-Datei zum Speichern umgewandelt.

- Cloud Storage Upload: Das Skript lädt die CSV-Datei in Google Cloud Storage hoch, wo sie später abgerufen werden kann.

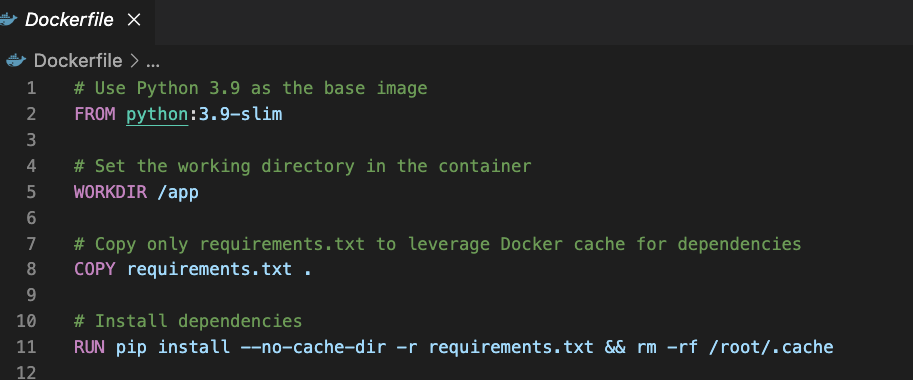

- Dockerfile Setup

Um das Python-Skript auf Google Cloud auszuführen, benötigen Sie eine Dockerfile, die die Umgebung für die Anwendung definiert. Docker ermöglicht es, die Anwendung zu „containerisieren“, was die Bereitstellung in Google Cloud vereinfacht.Die Datei requirements.txt enthält die notwendigen Bibliotheken wie google-api-python-client, google-auth und pandas. - Einrichten von Google Cloud und IAM

- Google Cloud APIs aktivieren: Aktivieren Sie in der Google Cloud-Konsole die Google Search Console API und die Google Cloud Storage API.

- Erstellen eines Servicekontos: Richten Sie ein Servicekonto mit den erforderlichen Berechtigungen ein, um auf die Google Search Console-Daten zuzugreifen und sie in Cloud Storage hochzuladen. Weisen Sie Rollen wie Viewer für die Search Console und Storage Admin für den Cloud-Storage-Bucket zu.

- Cloud Storage Bucket: Erstellen Sie einen Google Cloud Storage-Bucket, in dem die Backup-Dateien gespeichert werden. Stellen Sie sicher, dass der Bucket standardmäßig privat ist.

- Bereitstellung in Google Cloud Run

Um das Python-Skript zu automatisieren und bereitzustellen, verwenden Sie Google Cloud Run, mit dem Sie „containerisierte“ Anwendungen in einer Umgebung ohne eigene Server ausführen können.- Docker Image hochladen: Erstellen Sie das Docker-Image und laden Sie es in das Google Container Registry hoch.Bereitstellung in Cloud Run: Stellen Sie die containerisierte Anwendung in Cloud Run bereit.

- Automatisierung des Prozesses

Um sicherzustellen, dass das Backup regelmäßig läuft, können Sie es mit dem Google Cloud Scheduler auslösen. Richten Sie einen Cron-Job ein, um den Cloud Run-Dienst jeden Tag oder jede Woche zu starten, sodass Ihre Daten automatisch gesichert werden.

Kontaktieren Sie uns, und wir arrangieren diesen Service für Sie.

Alex ist ein erfahrener SEO-Berater mit über 14 Jahren Erfahrung in der Zusammenarbeit mit globalen Marken wie Montblanc, Ricoh, Rogue, Gropius Bau und Spartoo. Mit seinem Fokus auf datengesteuerte Strategien hilft Alex Unternehmen, ihre Online-Präsenz zu steigern und ihre SEO-Bemühungen zu optimieren.

Nach seiner Tätigkeit als Head of SEO bei Spreadshirt arbeitet er nun selbstständig und unterstützt Kunden weltweit mit dem Fokus auf digitale Transformation durch SEO.

Er hat einen MBA-Abschluss und eine Data-Science-Zertifizierung, wodurch er starke analytische Fähigkeiten für SEO mitbringt. Mit seiner Erfahrung in der Webentwicklung und Scrum-Methoden zeichnet er sich durch die Zusammenarbeit mit funktionsübergreifenden Teams aus, um skalierbare digitale Strategien umzusetzen.

Außerhalb der Arbeit liebt er Sport: Laufen, Tennis und Schwimmen im Besonderen!